組織のCopilot活用におけるセキュリティリスクと安全な生成AI管理とは?

Microsoft 365 Copilotは、業務効率化を加速させる強力な生成AIとして組織で利活用している企業も多いのではないでしょうか。企業での導入にあたっては、情報漏洩などのセキュリティ面におけるリスクの理解、対策が不可欠です。本記事では、法人向けのMicrosoft 365 Copilot 利用におけるセキュリティリスクと、IT部門・セキュリティ担当者が取るべき対策について解説します。

Copilotとは?

Microsoft 365 Copilot(以下、Copilot)とは、Microsoft社が提供する生成AIツールです。Word、Excel、PowerPoint、Outlook、TeamsといったMicrosoft 365アプリケーションに統合されており、Microsoft Graphと連携することで社内のメールやドキュメント、データを活用し、資料作成やメール文の作成、要約、翻訳などを行い、日常の業務効率化に繋がることから企業・組織における利用も進んでいるといわれています。

一方で、社内データにアクセスできるという点から、「情報漏洩のリスクはないのか?」といった懸念を持つ方もいるかもしれません。

Copilotの仕組み

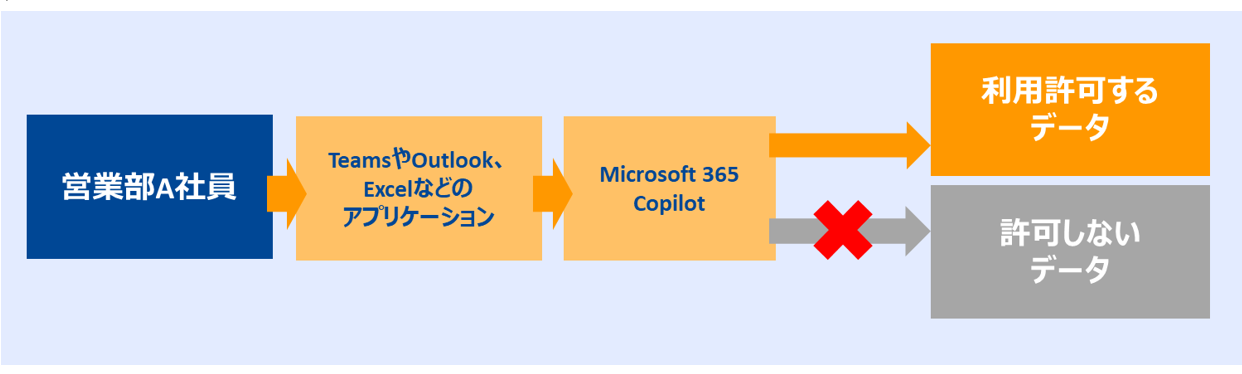

Copilotは、Microsoft 365ロールベースのアクセス制御に基づいて、アクセスを許可されているデータにのみアクセスする仕組みとなっています。そのため、利用ユーザがアクセス許可を持っていないデータにはアクセスができません。

例えば、CopilotにOutlookのデータ利用を許可していた場合でも、他の社員のメールデータにCopilotを通じてアクセスすることはできません。

また、ビジネス向けのプランでは、Microsoft 365に準じた多層的なセキュリティ対策が導入されており、社員がCopilotに入力した内容がAI学習に利用されることもありません。

Copilot利用におけるセキュリティリスク

一方で、組織におけるCopilot利用において気を付けるべきリスクもあります。

- 過剰な権限によるデータ漏洩

Copilotは、ユーザのアクセス権に基づいて情報を取得・生成するため、ユーザに過剰な権限が与えられている場合、Copilotが機密情報を意図せず回答する可能性があります。

例)営業部門や開発部門の正社員が、上層部の機密ファイルにアクセスできる設定になっていた場合、Copilotがその内容を含む回答を生成するリスクがあります。

- 誤情報の生成(ハルシネーション)

Copilotは、すべての回答が正確な情報とは限りません。誤った内容が業務における判断材料や外部への発信に利用されると、組織のイメージダウンなど悪影響を与える可能性があります。

- プロンプトインジェクション攻撃

悪意あるユーザが、Copilotに隠れた命令を埋め込むことで、生成AIから機密情報を引き出す「プロンプトインジェクション」の被害を受けるリスクがあります。

このリスクはCopilotに限らず、その他の生成AIサービスにおいても起こりうる攻撃です。

- サードパーティ連携による情報漏洩

Copilotはエージェントを使用して、サードパーティのツールとサービスを参照することもできます。そのため、利用する外部ツールによっては、セキュリティホールとなる場合があります。

リスクへの対策

これらのリスクに対してできる主な対策は以下の4点です。

1.アクセス権限の見直し

ユーザに必要最低限の権限のみを付与することで、Copilotがアクセスできる情報を制限します。

Microsoft Entra IDを活用して設定できます。

2.利用者教育とポリシー整備

社内研修などを通して生成AI利用におけるリスクや、Copilotの適切な利用方法を周知することに加えて、生成AI利用における社内のポリシーを明確化し、社内に共有することが重要です。

3.機密情報の書き込みを避ける・権限管理の徹底

プロンプトインジェクション攻撃による情報漏洩リスクを低減するためには、個人情報をCopilotに入力しない、また1つ目の対策案とも重複しますが、Microsoft Purviewなどを使用して権限管理を徹底することも情報漏洩対策として有効です。

4.ログ監視

Copilotの利用において、安全性を確証できるサードパーティのみ利用を許可するといったルールの策定に加えて、実際の利用ログを監視することで、適切な利用管理につなげることができます。

Copilotは、上記の通り、アクセス権限の管理などに配慮することで、安全に活用できるAIツールです。一方で、無償版のCopilotやその他の生成AIサービスを利用する場合には、誤情報の回答、プロンプトインジェクション攻撃のリスクに加え、Copilotとは異なった情報漏洩リスクがあるため注意が必要です。

その他の生成AIサービス利用における情報漏洩リスクと対策

ここまでご紹介した有償版のCopilot以外の生成AIを利用する際は、以下のようなリスクにも気を付ける必要があります。

1.生成AIに学習されることによる情報漏洩リスク

Copilotの無償版など一部サービスでは、ユーザが入力した情報がAIの学習に利用され、その結果、学習データが第三者への回答に反映される可能性があります。

2.生成AIサービスの脆弱性による情報漏洩リスク

安全性が確認されていない生成AIサービスでは、脆弱性が潜んでいる場合も高いです。入力したデータが保存される外部サーバーが攻撃を受けると、機密情報が漏洩する恐れがあるため、安全性を確証できていない生成AIサービスはより注意が必要です。

こうしたリスクをさらに高める要因が、組織が把握していない生成AIサービスを従業員が社用端末で無断利用する「シャドーAI」です。未承認サービスの利用は、AI学習による情報漏洩や脆弱性による攻撃リスクを増幅させます。

これらのリスクにおいては、以下の対策が大切です。

・機密情報や個人情報を生成AIに入力しないルールの策定と徹底

・安全性が確認されたサービスのみ利用可能とする社内ポリシーの整備・運用

・社員への教育・啓発の実施

安全な生成AI利用には、ルールを定め、指導するだけでは、実際に遵守されているかを把握することは困難であるため、生成AIサービス利用の管理体制の構築と利用状況の監視も不可欠です。

具体的な対策としては、生成AIサービスの利用管理、ログ分析による利用状況の可視化があります。

これらを実現するための有効な手段が、Webフィルタリングの導入です。Webフィルタリングを活用することで、未承認の生成AIサービスへのアクセスを制御し、シャドーAIの利用を防止できます。

生成AIへの安全な利用管理に

ALSIのクラウド型Webフィルタリング「InterSafe GatewayConnection」では、網羅率99%以上、150カテゴリ対応のURLデータベースで、きめ細かく安全なWebアクセス管理を実現します。

社内で安全な生成AI利用を管理するためには、「AI」カテゴリを活用することで、許可した生成AIサービス以外へのアクセスを簡単に制御可能です。さらに、アクセスログを活用し、どのサービスが頻繁に利用されているか、未承認のサービスへのアクセスを確認することができ、ポリシー改善や利用制限の判断材料としても利用いただけます。